In der Wissenschaft besteht Konsens, dass möglichst gute und verlässliche Temperaturdaten ein wichtiges Ziel sind – insofern sind die Bemühungen mancher Kritiker:innen lobenswert, der Frage der Datenqualität eine größere Öffentlichkeit zu verschaffen. Dennoch ist die Annahme falsch, verbesserte Temperaturerhebungen würden den Trend der globalen Erwärmung widerlegen oder stark relativieren.

Von Kritiker:innen der Klimawissenschaft wird gern ausgeblendet, dass es für die Aussagen zur Erdtemperatur eine große Zahl voneinander unabhängiger Messungen und Datenanalysen von vielen Forschungsteams überall auf der Welt gibt. Sie alle zeigen dieselbe Entwicklung: Dass sich die Erde seit einigen Jahrzehnten signifikant erwärmt. Wer diesen Fakt bestreiten will, müsste nachweisen, dass alle diese Daten fehlerhaft sind.

- Eine der meistgenutzten Datenreihen zu den Temperaturen an der Erdoberfläche stammt vom Goddard-Institut für Weltraumforschung (GISS) der US-Weltraumbehörde NASA. Sie stimmt mit zwei weiteren Analysen überein, die in den USA und Großbritannien unabhängig vom GISS erarbeitet werden: jener des Klimadatenzentrums (NCEI) der US-Ozean- und Atmosphärenbehörde (NOAA) und der Klimaforschungsabteilung (CRU) der University of East Anglia. Sie zeigen für die zweite Hälfte des 20. Jahrhunderts übereinstimmend Erwärmungstrends zwischen 0,10 und 0,12 °C pro Jahrzehnt. Das Tempo der Erwärmung hat sich zuletzt sogar noch erhöht, für den Beginn des 21. Jahrhunderts zeigen die Daten einen Trend zwischen 0,12 und 0,14 °C pro Jahrzehnt (IPCC 2021: AR6, Band 1, Kapitel 3, Cross-Chapter Box 3.1).

- Unabhängig von diesen traditionsreichen Institutionen hat ab dem Jahr 2010 das von einem damaligen Klima„skeptiker“ gegründete BEST-Forschungsprojekt der US-Universität Berkeley zur Temperatur der Erde geforscht, Datensätze überprüft und inzwischen etliche Studien veröffentlicht (Rohde et al. 2013 / Rohde et al. 2020). Ergebnis: Die Daten stimmen, der Klimawandel ist Realität. BEST-Gründer Richard A. Muller hat danach öffentlich erklärt, dass er die Temperaturdaten und die Erderwärmung nicht mehr bezweifelt.

- Wetterballonmessungen, die es seit den 1940er und 1950er Jahren gibt, haben ergeben, dass die globale durchschnittliche Lufttemperatur nahe der Erdoberfläche seit 1980 um ca. 0,74 bzw. 0,79 °C gestiegen ist (Raobcore/Rich in IPCC 2021, AR6, Band 1, Kapitel 2, Table 2.5).

- Satellitenmessungen von Temperaturen der unteren Erdatmosphäre ermittelten einen Anstieg von 0,51 °C bzw. 0,79 °C seit 1980 (UAH und RSS in IPCC 2021, AR6, Band 1, Kapitel 2, Table 2.5).

- Auch die Temperaturen an der Meeresoberfläche oder tiefer im Ozean zeigen deutlich eine langfristige Erwärmung (Palmer et al. 2007, Levitus et al. 2009, Lyman et al. 2010, Levitus et al. 2012, Cheng et al. 2020).

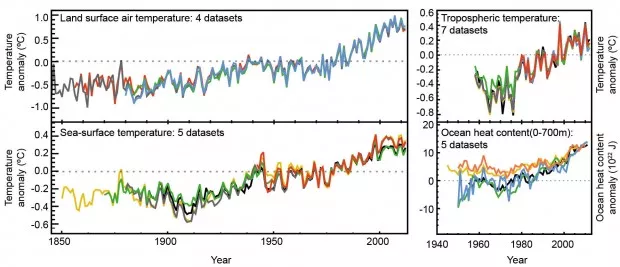

Die Vielzahl verschiedener Daten hat der IPCC in seinem Fünften Sachstandsbericht in einer Grafik zusammengestellt (WG1, Kapitel 2, Box FAQ 2.1; S. 199 in diesem pdf-Download) – Abbildung 1 ist ein Ausschnitt daraus:

Abbildung 1: Verschiedenste Datenreihen zum weltweiten Klima zeigen unabhängig voneinander einen Erwärmungstrend – Temperatur an der Erdoberfläche (links oben, vier Datensätze), Satellitenmessungen der unteren Erdatmosphäre (rechts oben, sieben Datensätze), Temperatur an der Meeresoberfläche (links unten, fünf Datensätze) und in den Ozeanen (0-700m Tiefe, rechts unten, fünf Datensätze); Quelle: IPCC 2013, AR5, WG1, Kap.2 Box FAQ 2.1, Abb.2 (Ausschnitt)

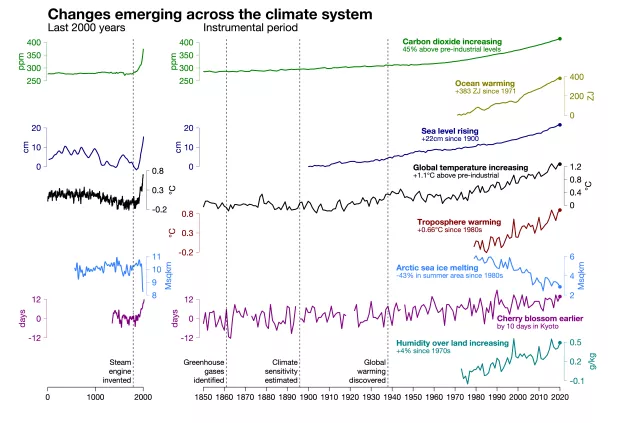

Für seinen Sechsten Sachstandsbericht 2021 erstellte der IPCC diese Grafik mit noch mehr Indikatoren bzw. Datensätzen:

Abbildung 2: Verschiedenste Datenreihen zum weltweiten Klima zeigen unabhängig voneinander einen Erwärmungstrend (von oben nach unten) – Konzentration von Kohlendioxid in der Atmosphäre, Wärmegehalt der Ozeane, globaler Meeresspiegel, globale Mitteltemperatur an der Erdoberfläche, globale Temperaturen der unteren Troposphäre, Fläche des arktischen Meereises, Datum der Kirschblüte im japanischen Kyoto, spezifische Luftfeuchte über Land. Am unteren Rand der Grafik sind Schlüsselmomente aus der Welthistorie bzw. der Geschichte der Klimaforschung genannt: die Erfindung einer leistungsfähigen Dampfmaschine durch James Watt 1790, die Identifizierung der primären Treibhausgase durch John Tyndall 1861, die erste Abschätzung der Klimasensitivität durch Svante Arrhenius 1896 und die Entdeckung der globalen Erwärmung durch Guy Callendar 1938. Diese Grafik entstammt der Arbeit am Sechsten IPCC-Sachstandsbericht, wurde aber bei dessen Publikation im August 2021 doch nicht mit aufgenommen. Der britische Klimaforscher Ed Hawkins veröffentlichte sie später auf seinem Online-Portal; Quelle: Climate Lab Book 2021

Neben diesen direkten Beobachtungsdaten gibt es auch eine ganze Reihe von Belegen für die Erderwärmung, die auf indirekt gewonnenen Daten basieren. So sind seit den 1970er Jahren hunderte Studien erschienen, die sogenannte Klima-Proxies auswerten. Unter einem „Proxy“ (engl. für „Stellvertreter“) versteht man in der Klimaforschung natürliche Temperaturarchive, etwa Baumringe, Korallen, Seesedimente oder Eisbohrkerne. An ihnen lässt sich das Klima der Vergangenheit ablesen, die wohl bekannteste Arbeit ist die sogenannte „Hockeyschläger-Kurve“ eines Teams um den US-Forscher Michael Mann. Diese und viele andere Untersuchungen zeigen übereinstimmend, dass die Erde heute so warm ist wie schon sehr lange nicht mehr.

Eine der aufwändigsten Untersuchungen veröffentlichte im Jahr 2013 das Forschungskonsortium „PAGES 2k“. Sie kam zu dem Ergebnis, dass die Erderwärmung der vergangenen rund hundert Jahre einen vorherigen, langanhaltenden Abkühlungstrend beendet hat und es sogar seit 1400 Jahren (weltweit betrachtet) keine so hohen Temperaturen gab wie derzeit. Der Sechste IPCC-Sachstandsbericht von 2021 blickt noch weiter zurück. Durch eine deutlich verbesserte Datenlage aus Klima-Proxyarchiven (Kaufman et al., 2020) wird deutlich, dass die Erwärmung der letzten Jahrzehnte seit mindestens 2000 Jahren beispiellos ist und womöglich sogar für die vergangenen 125.000 Jahre (IPCC 2021, AR6, Band 1, Summary for Policymakers, A2.2 und Figure SPM-1 sowie Kapitel 2, Figure 2.11 a).

Ein weiterer Beweisstrang sind sogenannte „Re-Analysen“. Dabei werden historische Messdaten nicht nur für Temperaturen, sondern auch für Parameter wie Luftdruck, Ozeantemperaturen oder Ausdehnung des Meereises zusammengetragen und in computerbasierte Klima- oder Wettermodelle eingespeist. Diese füllen dann zeitliche oder räumliche Lücken in den Messreihen, indem sie die Beobachtungen als Anfangszustand nutzen und einen konsistenten Satz an Vorhersagedaten produzieren. Re-Analysen sind also immer abhängig von den benutzten Beobachtungen und Modellsystemen, und stellen eine praktische, da homogenisierte Näherung an den wirklichen Klima- und Wetterverlauf dar.

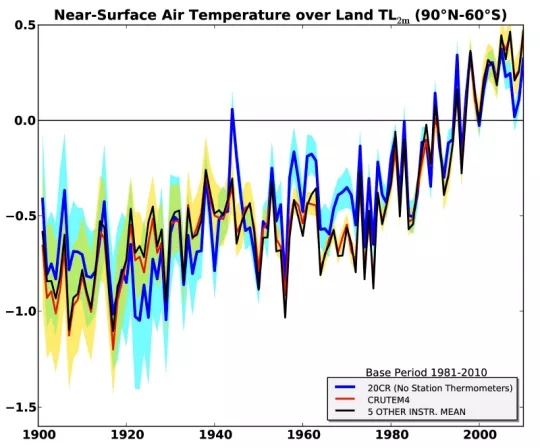

Bei diesen Re-Analysen fallen auch Fehler in einzelnen Messungen auf, weil sie aus dem insgesamt konsistenten Bild herausfallen. Auf diese Weise ermittelte zum Beispiel schon Compo et al. 2013 eine Temperaturkurve für das 20. Jahrhundert – und es zeigte sich, dass sie weitgehend deckungsgleich ist mit den oben erwähnten direkten Temperaturdatenreihen (Abbildung 3).

Abbildung 3: Entwicklung der Temperaturanomalie in zwei Metern Höhe über dem Boden seit 1900, Durchschnitt für nahezu die gesamte Erdoberfläche (90°N–60°S). Die rote Kurve zeigt die Datenreihe der britischen CRU, die schwarze Kurve den Durchschnitt fünf weiterer direkter Messreihen, blau dargestellt ist das Ergebnis der Re-Analyse (die gelbe bzw. blaue Flächen sind die jeweiligen Unsicherheitsmargen); Quelle: Compo et al. 2013

Auch andere Re-Analyse-Studien erbrachten ähnliche Resultate, etwa Anderson et al. 2012, bei der auf Basis von 173 indirekten Datenquellen ein historischer Temperaturverlauf rekonstruiert wurde, der die direkten Temperaturmessungen bestätigte. Oder Simmons et al. 2017, deren Studie nahelegte, dass die Erderwärmung zwischen 1998 und 2012 – eine Phase, die fälschlicherweise gelegentlich als Klimawandel-Pause (engl.: „hiatus“) bezeichnet wurde – stärker vorangeschritten ist als zuvor gedacht.

Justierung von Temperaturdaten zum Ausgleich lokaler Effekte

Trotz allem behaupten Kritiker der Klimawissenschaft bisweilen, die Temperaturdaten zur Erderwärmung würden durch die ungünstige Lage von Wetterstationen verfälscht, die Wärme von Städten etwa treibe die Messdaten künstlich nach oben. Dabei wird aber außer Acht gelassen, dass diese Möglichkeit den Klimaforscher:innen sehr bewusst ist und sie deshalb größte Sorgfalt bei der Erhebung von Temperaturdaten walten lassen. Beispielsweise werden langfristige Trends in Städten mit jenen der ländlichen Umgebung verglichen – und anschließend die städtischen an die ländlichen Entwicklungen angepasst. Diese Überprüfungs- und Bearbeitungsverfahren sind beispielsweise in den Guidelines zur „Homogenisierung“ der Weltwetterorganisation (PDF der 2020er-Ausgabe) ausführlich erläutert.

In einer Studie aus dem Jahr 2001 (Hansen et al. 2001) zu US-Wetterdaten, verfasst von Fachleuten der NASA und NOAA, zeigten übrigens 42 Prozent der Städte sogar niedrigere Temperaturen als ihre ländliche Umgebung, da städtische Wetterstationen oft an kühlen Orten aufgestellt werden, z. B. in Parks. Um verlässliche Daten zu erhalten, gibt es Standards für die Errichtung von Wetter-Messstationen – der Deutsche Wetterdienst (DWD) achtet beispielsweise darauf, dass seine Stationen nicht auf Hügeln oder in Senken liegen, wie viel Boden in der Nähe der Station versiegelt ist oder dass Bebauung oder Pflanzenwuchs im Umfeld sich nicht stark verändern.

Fazit

Entscheidend ist, dass der Forschung mögliche Fehlerquellen bei den Temperaturmessungen (etwa der Effekt Städtischer Wärmeinseln) bewusst ist und dass diese bei der Analyse der Daten berücksichtigt werden. Das passiert tatsächlich, wie auch der 2021 erschienene Sachstandsbericht des Weltklimarats betont. „So werden zum Beispiel die Temperaturmessungen von Thermometern in Städten bei der Berechnung der globalen Erwärmungstrends um diesen Effekt bereinigt“, heißt es dort (AR6, Band 1, FAQ 10.2).

Im Lichte der gesamten Forschungsergebnisse kam der Fünfte Sachstandsbericht des IPCC 2013 zur folgenden Einschätzung (AR5, Band 1, SPM, deutsche Übersetzung):

„Beobachtungen des Klimasystems beruhen auf direkten Messungen und Fernerkundung durch Satelliten und andere Plattformen. Beobachtungen im globalen Maßstab aus der Zeit der instrumentellen Messungen begannen Mitte des 19. Jahrhunderts bezüglich Temperatur und anderen Messgrößen, wobei umfassendere und unterschiedliche Beobachtungsdatensätze in der Zeit von 1950 an verfügbar sind. Paläoklima-Rekonstruktionen dehnen einige Messreihen um Hunderte bis zu Millionen Jahre zurück aus. Zusammen bieten sie eine umfassende Sicht über die Variabilität und Langzeit-Veränderungen in der Atmosphäre, dem Ozean, der Kryosphäre und der Landoberfläche.“

Acht Jahre später wurde dies im Sechsten Sachstandsbericht um eine unmissverständliche Bewertung ergänzt (AR6, Band 1, SPM, deutsche Übersetzung):

„Seit dem AR5 bieten Verbesserungen von beobachtungsbasierten Angaben und Informationen aus paläoklimatischen Archiven ein umfassendes Bild der einzelnen Komponenten des Klimasystems und ihrer bisherigen Veränderungen. Neue Klimamodellsimulationen, neue Analysen und Methoden, die Belege aus mehreren unterschiedlichen Untersuchungsansätzen kombinieren, führen zu einem verbesserten Verständnis des menschlichen Einflusses auf ein breiteres Spektrum von Klimavariablen, einschließlich Wetter und Klimaextreme. […] Es ist eindeutig, dass der Einfluss des Menschen die Atmosphäre, den Ozean und die Landflächen erwärmt hat. Jedes der vergangenen vier Jahrzehnte war jeweils wärmer als alle Jahrzehnte davor seit 1850. […] Das Ausmaß der jüngsten Veränderungen im gesamten Klimasystem – und der gegenwärtige Zustand vieler Aspekte des Klimasystems – sind seit vielen Jahrhunderten bis Jahrtausenden beispiellos.“

John Cook/klimafakten.de, November 2011;

zuletzt aktualisiert: Juli 2022